После добавления наших нод по нашей прошлой инструкции:

☸️ Как добавить рабочие ноды в кластеры Kubernetes

и решением ошибки с Calico k8s:

Я наткнулся еще на некоторые проблемы в моем кластере.

Оказалось не все ноды смогли успешно запуститься.

Проблема была связано с компонентом Kubelet.

При запуске статуса всех подов, я вижу положительных вывод:

kubectl get pods --all-namespaces NAMESPACE NAME READY STATUS RESTARTS AGE default minio-7fcf7bdfb5-xzdd9 1/1 Running 0 17d default minio-deployment-5496b7cf8c-75j75 1/1 Running 0 18d default pilfering-ant-consul-88r7n 1/1 Running 0 27d default pilfering-ant-consul-8x2hq 1/1 Running 1 27d default pilfering-ant-consul-connect-injector-webhook-deployment-6jwmfq 1/1 Running 0 27d default pilfering-ant-consul-jz8gk 1/1 Running 0 27d default pilfering-ant-consul-server-0 1/1 Running 0 27d default pilfering-ant-consul-sync-catalog-698d66b9bd-j59wx 1/1 Running 21 27d default pilfering-ant-consul-td74k 1/1 Running 0 27d default vault-6cbbc5474d-hkmzp 1/1 Running 1 44d kube-system calico-kube-controllers-6d57b44787-xlj89 1/1 Running 35 73d kube-system calico-node-dwm47 1/1 Running 311 67d kube-system calico-node-hhgzk 1/1 Running 30 73d kube-system calico-node-j2jr5 1/1 Running 11 85m kube-system calico-node-k8lv6 1/1 Running 783 2d18h kube-system calico-node-l4b49 1/1 Running 17 92m kube-system calico-node-tk4mp 1/1 Running 322 67d kube-system calico-node-w7zvs 1/1 Running 325 67d kube-system coredns-74c9d4d795-jztfd 1/1 Running 0 39d kube-system coredns-74c9d4d795-psf2v 1/1 Running 15 66d kube-system dns-autoscaler-7d95989447-7kqsn 1/1 Running 23 73d kube-system kube-apiserver-master 1/1 Running 18 73d kube-system kube-controller-manager-master 1/1 Running 16 73d kube-system kube-proxy-7q98r 1/1 Running 0 2d18h kube-system kube-proxy-9bt8m 1/1 Running 4 67d kube-system kube-proxy-cbrcl 1/1 Running 18 67d kube-system kube-proxy-ftt4p 1/1 Running 1 92m kube-system kube-proxy-gqmqc 1/1 Running 0 85m kube-system kube-proxy-stj5g 1/1 Running 2 67d kube-system kube-proxy-zql86 1/1 Running 3 67d kube-system kube-scheduler-master 1/1 Running 18 73d kube-system kubernetes-dashboard-7c547b4c64-6skc7 1/1 Running 606 73d kube-system nginx-proxy-worker1 1/1 Running 4 67d kube-system nginx-proxy-worker2 1/1 Running 3 67d kube-system nginx-proxy-worker3 1/1 Running 2 67d kube-system nodelocaldns-2bk4x 1/1 Running 0 85m kube-system nodelocaldns-6t92x 1/1 Running 4 67d kube-system nodelocaldns-8r9v8 1/1 Running 1 92m kube-system nodelocaldns-hhj8t 1/1 Running 0 2d18h kube-system nodelocaldns-kgm4t 1/1 Running 2 67d kube-system nodelocaldns-xl8zg 1/1 Running 3 67d kube-system nodelocaldns-xwlwk 1/1 Running 25 73d kube-system rbd-provisioner-667754f947-h4f5d 1/1 Running 0 13d kube-system tiller-deploy-8557598fbc-wnml4 1/1 Running 0 39d rook-ceph csi-cephfsplugin-85mgd 3/3 Running 0 6d23h rook-ceph csi-cephfsplugin-dndcc 3/3 Running 0 6d23h rook-ceph csi-cephfsplugin-provisioner-974b566d9-kr86d 4/4 Running 0 6d23h rook-ceph csi-cephfsplugin-provisioner-974b566d9-zhhbk 4/4 Running 0 6d23h rook-ceph csi-cephfsplugin-tth6v 3/3 Running 0 6d23h rook-ceph csi-cephfsplugin-zhhpf 3/3 Running 0 6d23h rook-ceph csi-rbdplugin-2b7bt 3/3 Running 0 6d23h rook-ceph csi-rbdplugin-hqkqd 3/3 Running 0 6d23h rook-ceph csi-rbdplugin-hwm9c 3/3 Running 0 6d23h rook-ceph csi-rbdplugin-provisioner-579c546f5-txhxp 5/5 Running 0 6d23h rook-ceph csi-rbdplugin-provisioner-579c546f5-w8vmk 5/5 Running 0 6d23h rook-ceph csi-rbdplugin-tdswl 3/3 Running 0 6d23h rook-ceph rook-ceph-mgr-a-74f77f669-zv4lw 1/1 Running 0 6d23h rook-ceph rook-ceph-mon-a-84c4f57596-qbr86 1/1 Running 0 6d23h rook-ceph rook-ceph-operator-54665977bf-4p2dz 1/1 Running 0 6d23h rook-ceph rook-ceph-osd-0-6ffd9c79ff-ql8tz 1/1 Running 0 6d23h rook-ceph rook-ceph-osd-1-78f4d69464-nnvwx 1/1 Running 0 6d23h rook-ceph rook-ceph-osd-2-6484c8966f-62p86 1/1 Running 0 6d23h rook-ceph rook-ceph-osd-3-79567f7956-9f9br 1/1 Running 0 6d23h

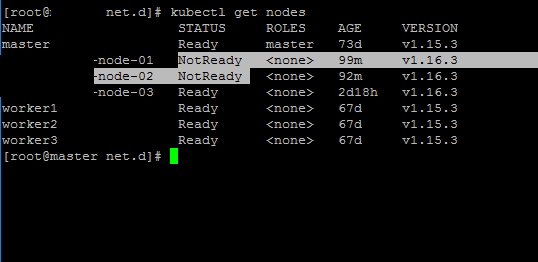

Однако, при запуске статуса узлов, не все так радужно, некоторые в статусе NotReady

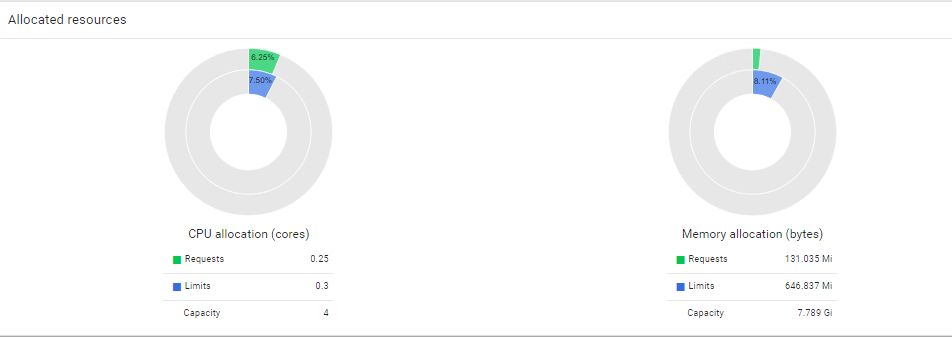

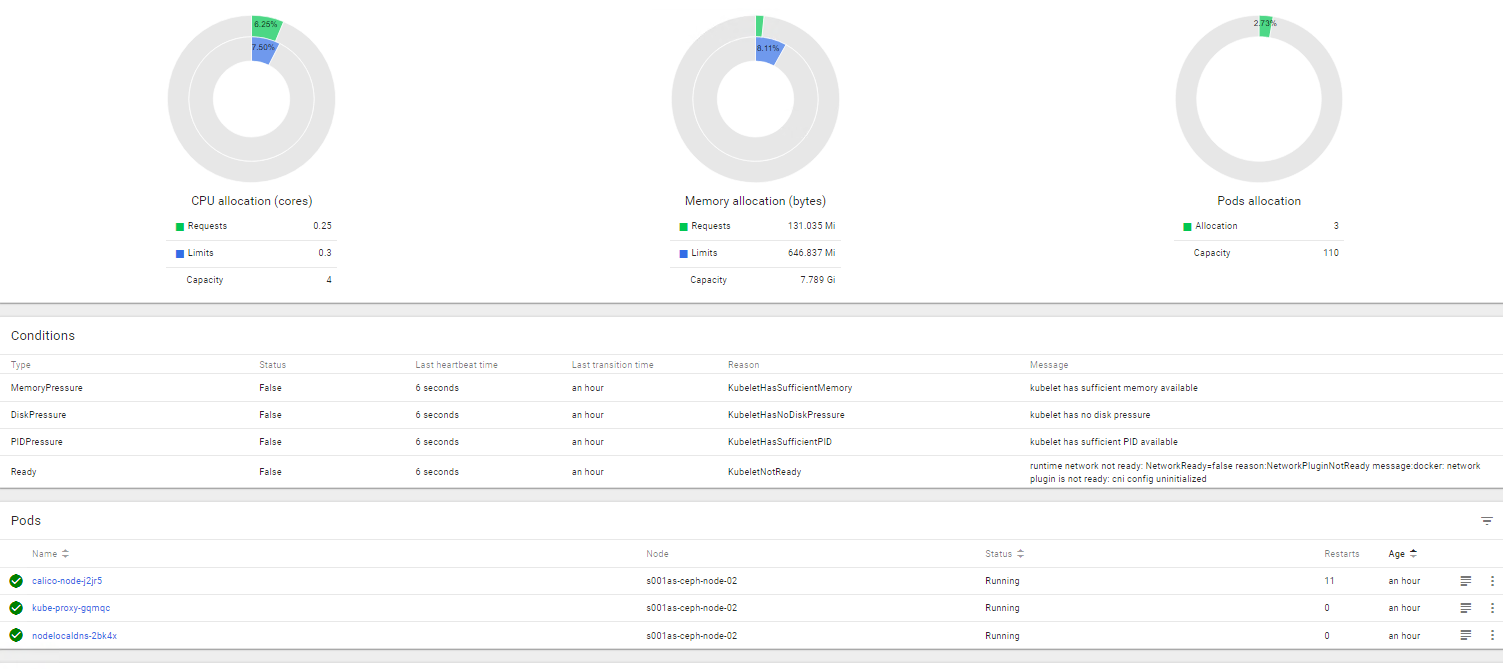

В веб-панели Kubernetes увидел следующие ошибки в каждой новой ноде:

-

KubeletHasSufficientMemory kubelet has sufficient memory available

-

KubeletHasNoDiskPressure kubelet has no disk pressure

-

KubeletHasSufficientPID kubelet has sufficient PID available

-

KubeletNotReady runtime network not ready: NetworkReady=false reason:NetworkPluginNotReady message:docker: network plugin is not ready: cni config uninitialized

Итак, недолго пронализировав всю это историю, я выяснил что корень зло в последней ошибке CNI config.

Решение оказалось также довольно примитивным.

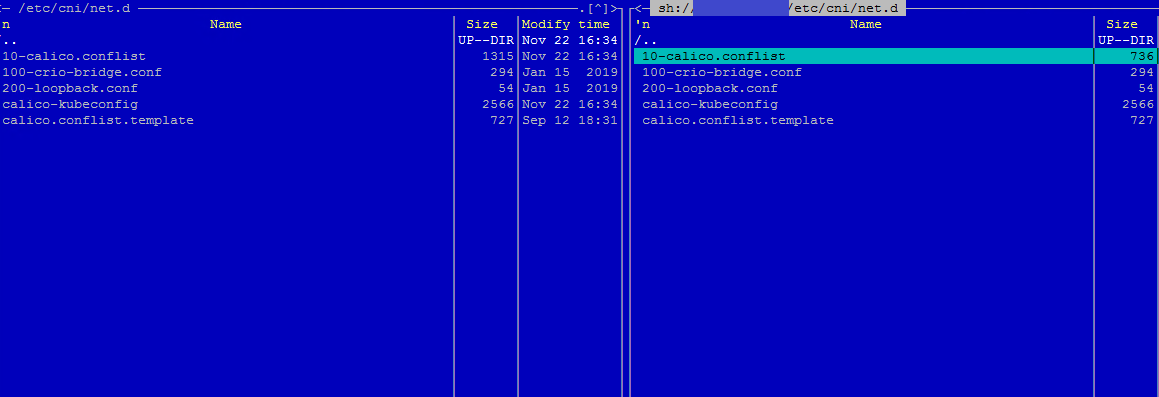

Для решения понадобилось скопировать файлы из каталога /etc/cni/net.d/ Мастер ноды в новые рабочие ноды!